Termin “deepfake”, koji označava manipulirani audio-vizualni, grafički ili tekstualni zapis stvoren uz pomoć umjetne inteligencije, u masovnu je uporabu ušao prije četiri godine. Međutim, unatoč tome što širenje i popularnost takvog sadržaja nosi brojne rizike, zakonska regulativa tog fenomena na razini EU i dalje je nedostatna.

Jedan je to od zaključaka studije koju je prošli mjesec objavio Panel za budućnost znanosti i tehnologije Europskog parlamenta, i u kojoj se analiziraju potencijali i rizici korištenja takve tehnologije u budućnosti.

Prijavite se na F-zin, Faktografov newsletter

Prijavom pristajete na Uvjete korištenja i Politiku privatnosti.

U izvješću je izraz “deepfake” definiran kao sintetički zapis koji izgleda autentičan i koji prikazuje ljude za koje se čini da govore ili rade nešto što nikada nisu rekli ili učinili. Zbog sve više takvog sadržaja, neki znanstvenici predviđaju mogućnost ‘infokalipse’, mračne vizije budućnosti u kojoj više ne vjerujemo digitalnom sadržaju jer bi sve što vidimo moglo biti izmanipulirano.

Takav ishod bi mogao izazvati eroziju povjerenja i destabilizirajući učinak na društvo.

Rast i potencijal

Ublažavanju štetnih posljedica tog trenda ne ide u prilog činjenica da je deepfake sve lakše i sve jeftinije napraviti.

Uostalom, tehnologija koja to omogućuje već je dostupna u našim džepovima. Kako se navodi u izvještaju, mobilnu aplikaciju FaceApp, koja omogućuje korisnicima promjenu vlastitih slika tako da vide kako će izgledati u starosti, sredinom 2019. godine preuzelo je više od 150 milijuna korisnika. Aplikacija Wombo koja primjenjuje tehnologiju sinkronizacije usana “skinuta” je više od 2 milijuna puta u prva dva tjedna nakon objavljivanja. Osim toga, na tržištu su se već počele pojavljivati komercijalne tvrtke koje nude izradu deepfake sadržaja.

Razvoj takve tehnologije donosi nove mogućnosti, a njihova primjena može imati i pozitivne učinke u nizu sektora.

Filmske produkcije tako mogu popraviti pogrešno izgovorene rečenice presnimavanjem glasa ili, recimo, stvoriti deepfake zapis glumca koji govori različite jezike, što može pojeftiniti i olakšati produkciju. Tvrtke koje proizvode računalne igre također koriste deepfake za stvaranje brojnih 3D modela iz igre.

Deepfake tehnologija može se koristiti i za poboljšanje interakcije između ljudi i računala, odnosno, za virtualne pomoćnike koji će s vremenom sve više nalikovati na ljude. Korisne primjene deepfakea mogu se naći i u medicini, kao što je na primjer stvaranje glasa za gluhonijeme osobe (1,2).

Rizici

Ono što zabrinjava jesu mnogobrojni rizici koje donosi primjena ove tehnologije u političke svrhe, za manipuliranje sudskim dokazima te za stvaranje lažnih pornografskih videa.

Primjer iz afričke države Gabon pokazuje kako takav sadržaj (čak i kad nije jasno je li deepfake) može imati negativni utjecaj na vladavinu prava.

Predsjednik te države, Ali Bong, mjesecima nije viđen u javnosti, što je potaknulo glasine kako on nije dovoljno zdrav za taj posao ili da je umro. Tim je povodom na televiziji prikazana video poruka u kojoj Bong drži govor. On u njoj djeluje ukočeno te neprirodno, pa je video odmah rasplamsao sumnje da vlada nešto skriva od javnosti. Bongovi su protivnici izjavili da je predsjednik onesposobljen ili mrtav, i te su se glasine ubrzo proširile društvenim mrežama.

Politička situacija u Gabonu brzo se destabilizirala te je u roku od tjedan dana vojska pokrenula državni udar, navodeći novogodišnji video kao dokaz da s predsjednikom nešto nije u redu. Puč nije uspio, Ali Bong je ostao predsjednik, a stručnjaci do danas ne mogu definitivno reći je li novogodišnji video bio lažan (Washington Post).

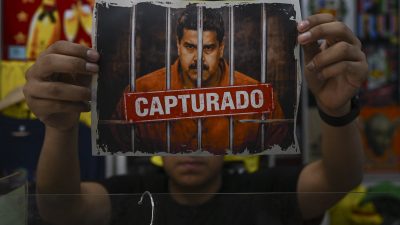

Protagonisti deepfake video zapisa često su političari. Umjetna je inteligencija tako proizvela lažnog Mauricia Macrija, argentinskog predsjednika, njemačku kancelarku Angelu Merkel, belgijsku premijerku Sophie Wilmes te brazilskog predsjednika Jaira Bolsonara (1, 2, 3 , 4).

Bivši američki predsjednik Donald Trump također je bio meta deepfakea – zaposlenik televizije koja je dio Foxa 2019. godine dobio je otkaz zašto što je izmanipulirao video Donalda Trumpa na kojem bivši američki predsjednik plazi jezik dok drži govor i na kojem su njegova koža i kosa izgledali narančasto.

Rodna dimenzija

Deepfake kao fenomen ima i rodnu dimenziju. Prema istraživanju tvrtke Sensity AI, oko 90 do 95 posto deepfake videa odnosi se na pornografiju bez pristanka te na osvetničku pornografiju, a u 90 posto tih videa žrtve su žene.

Ista tvrtka je 2020. godine izvijestila kako se na aplikaciji Telegram pojavio chat bot koji omogućava korisnicima jednostavno stvaranje deepfake golih fotografija, u kojima su žrtve – preko 100.000 – isključivo žene. (Wired). U izvještaju Panela za budućnost znanosti i tehnologije također se ističe kako su aplikacije za deepfake pornografiju najčešće programirane za žensko tijelo.

Deepfake pornografija ne nanosi štetu samo ženama čija se lica pojavljuju u videima, već i porno glumicama čija se tijela koriste i koje tako gube kontrolu nad time gdje se sve šire isječci u kojima se pojavljuju. Stoga se može reći da se u takvim slučajevima radi o dvostrukoj eksploataciji žena.

Utjecaj na pravosuđe

Deepfake, kao i svaki lažni dokaz koji ne prikazuje realno stanje stvari, predstavlja rizik i za pravosudni sustav.

Prije svega, takav materijal može imati utjecaj na osumnjičene ili stranke u parničnom postupku, a u najgorem slučaju osumnjičeni može dobiti kaznu na temelju lažnih dokaza.

Osim toga, pravni stručnjaci brinu o mogućnosti osumnjičenika da tvrdi da je bilo koji dokaz lažan ili izmišljen, što može ometati učinkovito procesuiranje predmeta.

“Umjesto da dokaže da je okrivljenik počinio zločin, tužiteljstvo će sada morati dokazati da su dokazi poput audio ili video zapisa autentični i da se njima ne manipulira. To može biti teško ili čak nemoguće”, navodi se u izvješću Panela.

Slični su se slučajevi, uostalom, već događali. Iz Velike Britanije stiže primjer žene koja je optužila muža za zlostavljanje te kao dokaz priložila snimku u kojoj joj muž navodno prijeti, a koja se pokazala kao lažna.

U studiji se ističe kako znanstvenici predviđaju da će do 2022. godine većina ljudi konzumirati više lažnih nego istinitih informacija. Kako postaje sve teže reći što je stvarno, sudovi i porotnici mogu početi ispitivati autentičnost svakog dokaza, što ima potencijalno korozivan učinak na pravosudni sustav.

I izvješće koje je Europol objavio prošle godine naglašava mogućnost zlouporabe deepfakea, zbog čega se preporučuje agencijama za provedbu zakona da uspostave naprednija sredstva za otkrivanje novih generacija manipuliranog sadržaja.

Detekcija

Detekcija deepfakea, odnosno algoritama koji ga razotkrivaju, svojevrsna je igra mačke i miša jer povećana mogućnosti otkrivanja dubinskog lažiranja vodi ka povećanoj kvaliteti dubinski lažnih videozapisa. Osim toga, navodi se u izvješću, detektori su dobri u otkrivanju samo jedne vrste deepfakea, a problem im stvara to što je audio-grafički materijal često smanjene kvalitete i rezolucije kada se dijeli na društvenim mrežama, ili putem aplikacija za chat.

“Smanjenje broja piksela, kompresija zvuka i slike mogu ometati sposobnost otkrivanja deepfakea. Također, aplikacije za kameru na pametnom telefonu često imaju automatski omogućene filtre koji mijenjaju svaku sliku ili video zapis, poništavajući na samom početku postojanje autentične slike”, stoji u izvješću.

Kako je sve krenulo?

Prvi programi za manipulaciju slikom razvijeni su još 70-ih, iako je tek popularnost Photoshopa u devedesetima tu mogućnost otvorila široj javnosti. Kvalitetnu manipulaciju video zapisima sve donedavno najviše je koristila kinematografska industrija, međutim, razvoj algoritama koji mapiraju “točke” lica, kao na primjer nosa ili usana (što je dovelo i do tehnologije za prepoznavanje lica) te rast broja platformi za razmjenu videa i fotografija potaknuli su masovniju proizvodnju deepfakea.

Fenomenu je pridonijela i činjenica da se u internetskim prostranstvima nalazi gomila fotografija i video zapisa slavnih osoba, zbog čega je autorima manipuliranih videa lakše stvoriti takav sadržaj.

Kao termin, deepfake se počeo koristiti nakon što je anonimni korisnik društvene mreže Reddit 2017. godine, koji je profil nazvao upravo “deepfake”, objavio manipulirane videozapise i podijelio programski kod koji je omogućio drugim korisnicima da slijede primjer. Prvi video zapisi sadržavali su pornografski sadržaj u kojem su lice originalne glumice zamijenila lica slavnih glumica Taylor Swift i Scarlett Johansson.

Lažni Obama

Korištenje umjetne inteligencije za stvaranje sintetičkih video zapisa tih se godina izučavalo i na akademskoj razini.

Istraživačima sa Sveučilišta u Washingtonu 2017. godine uspjelo je stvoriti lažnog Baracka Obamu u sintetičkom videozapisu napravljenom pomoću umjetne inteligencije. Snimka lažnog Obame napravljena je tako da je donji dio njegova lica zamijenjen s “modelom” koji je napravljen uz pomoć 14 sati dugog video materijala bivšeg predsjednika (BBC).

Godinu dana poslije, Buzzfeed je objavio još jedan “deepfake” video s Obamom kojem je namjera bila upozoriti čitatelje na opasnosti tog fenomena, odnosno kako nešto može izgledati autentično, iako to nije (Buzzfeed). Tada se predviđalo kako će takvih video zapisa u budućnosti biti sve više, što su ubrzo i potvrdile brojke. Prema izvješću tvrtke Deeptrace, početkom 2019. godine na internetu je bilo 7.964 deepfake videa, a samo devet mjeseci kasnije ta je brojka skočila na 14.678 (Forbes).

Širenje deepfakea odvija se paralelno sa sve većim brojem dezinformacija, u “post-činjenično” doba kada sve više ljudi gubi povjerenje u tradicionalne medije, ali i u znanstvene autoritete. Osim toga, komunikacija na internetskim platformama postaje sve više vizualna. Ljudi dijele sve više svojih fotografija na društvenim mrežama, što povećava mogućnost manipulacije sadržajem.

Zakonska regulativa

Europska komisija objavila je u travnju ove godine prijedlog Uredbe o europskom pristupu umjetnoj inteligenciji, koji nadopunjuje Bijelu knjigu o umjetnoj inteligenciji i druge rezolucije Europskog parlamenta koje su usvojene tijekom 2020. godine.

Uredbom se propisuju obveze koje treba poštivati pri razvoju i korištenju umjetne inteligencije te se nastoji zabraniti uporabu sustava koji bi predstavljao neprihvatljiv rizik za sigurnost i temeljna prava građana EU. Komisija pritom pravi razliku između „neprihvatljivog rizika“, „visokog rizika“, „ograničenog rizika“ i „minimalnog rizika“.

Za sustave umjetne inteligencije koji spadaju u kategoriju visokog rizika, davatelji usluga bili bi obvezni provoditi procjene rizika, osigurati dokumentaciju i ljude nadzirati i osigurati visokokvalitetne skupove podataka, između ostalih zahtjeva. Samo za određene AI sustave formulirani su minimalni zahtjevi, dok aplikacije koje predstavljaju minimalan rizik neće biti regulirane.

Prijedlog dopušta upotrebu sintetičkog audio-vizualnog sadržaja, ali artikulira neke zahtjeve, a ponajviše u pogledu obveze transparentnosti. Tvorci deepfakea, naime, dužni su označiti svoj sadržaj kao takav.

Nevladina organizacija European digital rights (EDRI) ističe kako je prijedlog Uredbe globalno značajan korak, no upozorava da i dalje sadrži neke praznine.

Iako otvara vrata nekim potencijalno učinkovitim načinima za smanjenjem rizika umjetne inteligencije, on ne ide dovoljno daleko da bi u potpunosti zaštitio ljude od svih mogućih štetnih utjecaja. Naglašava se zabrinutost oko scenarija u kojem će privatne tvrtke steći nedemokratski stupanj moći nad javnim tijelima jer će postavljati pravila kako ta tijela moraju koristiti sustave umjetne inteligencije.

Ono što organizaciju najviše zabrinjava jest korištenje umjetne inteligencije, prije svega tehnologije prepoznavanja lica, u svrhu masovnog nadzora, o čemu smo više pisali u ovom tekstu.

Paralelno s donošenjem prijedloga Uredbe, na razini Vijeća Europe raspravlja se o budućoj regulativi za zaštitu ljudskih prava, demokraciju i vladavinu prava u svjetlu rizika i izazova koje donosi umjetna inteligencija.

Ostali pravni okviri

Stvaranje deepfakea obično uključuje korištenje fotografija ili glasa određene osobe, što su podaci pomoću kojih se pojedinac može identificirati. Stoga ovo pitanje spada i pod područje koje regulira Opća uredba o zaštiti podataka (GDPR) koja tako, na primjer, štiti podatke pojedinaca koji koriste aplikacije s deepfake tehnologijom kao što su FaceApp i TikTok.

U studiji Panela ističe se kako GDPR nudi značajne smjernice za rješavanje nezakonitog dubinski lažnog sadržaja i pruža žrtvama pravo na ispravljanje netočnih podataka ili brisanje. Osim toga, u svakoj državi članici postoji barem jedno neovisno nadzorno tijelo odgovorno za provedbu propisa.

“Međutim, u kontekstu dubokih krivotvorina pravni put za žrtve može biti prilično izazovan. U mnogim slučajevima žrtvi će biti nemoguće identificirati počinitelja, koji često djeluje anonimno. Štoviše, žrtvama možda nedostaju odgovarajući resursi potrebni za početak i sudski postupak, što ih ostavlja ranjivima”, navodi se.

Osim toga, stvaranje deepfakea obično uključuje korištenje materijala koji može biti zaštićen zakonom o autorskim pravima, a područjem manipuliranih sintetičkih zapisa koji su stvoreni uz pomoć umjetne inteligencije, barem u onom dijelu koji se odnosi na zaštitu maloljetnika, bavi se i Direktiva o audio-vizualnim medijskim uslugama.

Budući da je Komisija najavila usklađivanje pravila odgovornosti i obveza moderiranja sadržaja za digitalne platforme, usluge i proizvode, pitanjem deepfakea trebao bi se baviti i Akt o digitalnim uslugama, prijedlog zakonodavnog paketa koji je predstavljen krajem prošle godine.

Krajem 2019. godine internetski divovi poput Mozille, Twittera, Facebooka i Googlea potpisali su Kodeks dobre prakse u suzbijanju dezinformacija, svojevrsni poziv da se platforme dobrovoljno podvrgnu najboljoj praksi kako bi postigle veću transparentnost i odgovornost. Kodeks sugerira mjere poput zatvaranja lažnih računa ili sprječavanja botova, a njime se također nastojalo utjecati na političko oglašavanje na internetu.

“Nekoliko je studija, međutim, pokazalo da Kodeksu nedostaje značajna mogućnost mjerenja učinkovitosti te da objavljena izvješća o transparentnosti često nisu sadržavala važne informacije. Zbog toga je učinkovitost i djelotvornost samog Kodeksa dovedena u pitanje”, navodi se dalje u studiji.

Tim se problemom bavi i Akcijski plan za europsku demokraciju koji je predstavljen u prosincu 2020., i koji najavljuje da će se postojeći Kodeks pretvoriti u temeljni regulatorni okvir u skladu s Aktom o digitalnim uslugama, a sve radi jačanja odgovornosti operatora platformi.

Trendovi u SAD-u

Kalifornija i Teksas bile su prve države koje su 2019. godine donijele zakone koje reguliraju deepfake, barem u dijelu koji se odnosi na političke kampanje. Prema kalifornijskom zakonu, nije dozvoljeno distribuirati manipulirani sadržaj vezan za političare u roku od 60 dana prije izbora, sve kako se ne bi naštetilo kandidatu te zavaralo birače. Teksaški zakon vrlo je sličan kalifornijskom, ali zabranjuje samo distribuciju u roku od 30 dana.

Oba zakona privukla su značajne kritike, a posebno se dovodila u pitanje njihova kompatibilnost s pravom na slobodu govora. Tako je 2019. godine, kada je obavještajni odbor Predstavničkog doma imao saslušanje na temu deepfakea, američka neprofitna organizacija The Electronic Frontier Foundation upozorila da u reguliranju tog fenomena treba biti oprezan kako se ne bi ograničile umjetničke slobode te pravo na slobodu govora.

Umjesto regulacije, SAD se usredotočio na samo istraživanje fenomena. Ovogodišnji Zakon o odobrenju nacionalne obrane (National Defense Authorization Act, NDAA) zatražio je od Odjela za nacionalnu sigurnost da provede petogodišnju analizu o tome kako strane vlade koriste deepfake, odnosno na koje bi sve načine taj fenomen mogao naškoditi javnosti.

Deepfake i AI u Hrvatskoj

Konkretan korak u reguliranju deepfakea u Hrvatskoj, u dijelu koji se odnosi na lažne osvetničke pornografske snimke, napravljen je najavom izmjena Kaznenog zakona koje bi se dotakle takvih video materijala i prema kojima bi objavljivanje takvih snimki bilo kazneno djelo. Izmjene i dopune upućene su u saborsku proceduru te se o njima raspravljalo početkom srpnja (Index). Značajan je to korak kada se uzme u obzir da Hrvatska kasni u promišljanjima o utjecaju umjetne inteligencije i budućnosti njenog razvoja.

Naime, nakon što je u travnju ove godine Komisija objavila prijedlog Uredbe o umjetnoj inteligenciji, Ured pučke pravobraniteljice upozorio je kako Hrvatska još nije donijela Strategiju razvoja umjetne inteligencije, koju je prema Koordiniranom planu za razvoj umjetne inteligencije u EU trebala donijeti do kraja 2019.

Taj bi dokument trebao biti ključan za razumijevanje načina na koji se Uredba primjenjuje u odnosu na Hrvatsku, međutim, radna skupina tadašnjeg Ministarstva gospodarstva, poduzetništva i obrta, koje je najavilo da će strategija biti gotova do kraja 2019. godine, posao pripremanja smjernica još nije završila.

*Ovaj tekst nastao je uz potporu Fonda za poticanje pluralizma i raznovrsnosti elektroničkih medija